Uma equipe da empresa de cibersegurança Kaspersky encontrou cerca de 3.000 postagens em fóruns da dark web no ano passado discutindo o uso do ChatGPT e modelos de aprendizado de máquina (LLM) para atividades ilegais. O estudo realizado através do serviço Digital Footprint Intelligence da Kaspersky foi publicado pela entidade na semana passada.

De acordo com relatório, os maus atores têm explorado várias alternativas de inteligência artificial (IA) para cometerem crimes cibernéticos, incluindo chatbots — programas que tentam simular a interação humana, e jailbreakings, que é o processo de exploração de falhas de um dispositivo eletrônico bloqueado para instalar outro software que não o disponibilizado pelo fabricante.

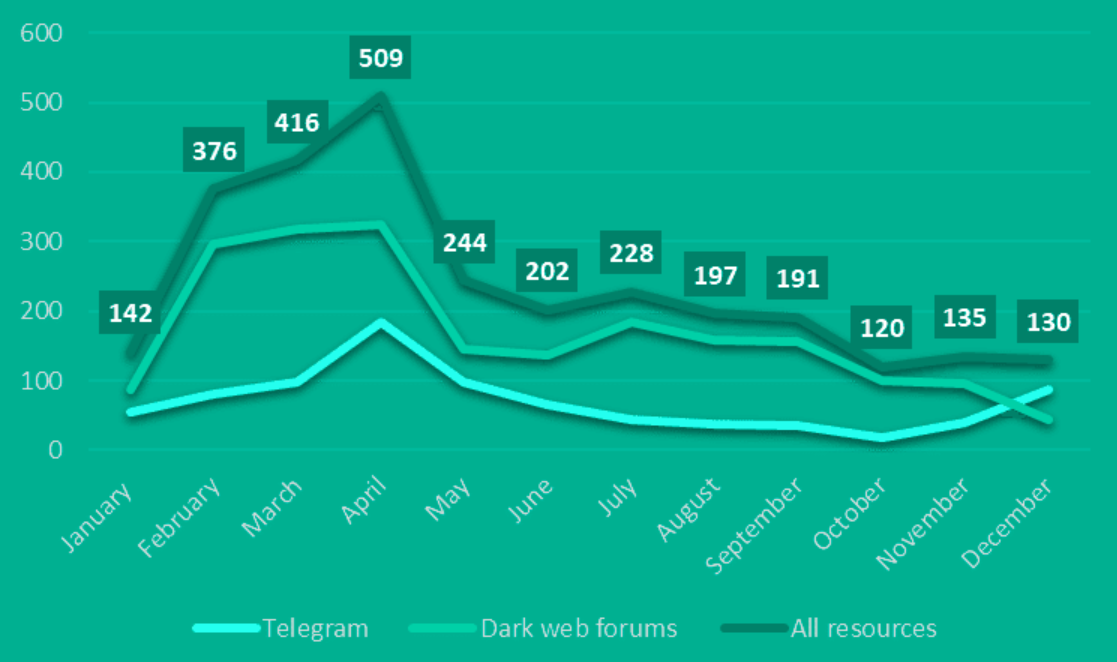

Segundo a Kaspersky, as conversas na dark web discutindo o uso de ferramentas de IA para fins ilegais atingiram o pico em março de 2023, enquanto as discussões persistiram durante o resto do ano, como mostra a figura abaixo.

A mesma quantidade aproximada de discussão se refere a roubos de contas e serviços ChatGPT. Neste caso, os ameaçadores oferecem sua criação automatizada em massa, que vem inundando os canais da dark web.

“Os tópicos frequentemente incluem o desenvolvimento de malware e outros tipos de uso ilícito de modelos de linguagem, como processamento de dados roubados de usuários, análise de arquivos de dispositivos infectados e muito mais”, comenta a analista da Kaspersky, Alisa Kulishenko.

A especialista diz que a popularidade das ferramentas de IA levou à integração de respostas automatizadas do ChatGPT ou seus equivalentes em alguns fóruns de cibercriminosos. “Além disso, os agentes de ameaças tendem a compartilhar jailbreaks por meio de vários canais da dark web e criar maneiras de explorar ferramentas legítimas”, acrescenta.

O estudo diz ainda que vale considerar ameaças de outras vertentes de IAs, como os projetos “XXXGP e FraudGPT”, que são modelos de linguagem sem limitação, ou seja, perigosos, comercializados na dark web.

“Embora as ferramentas de IA em si não sejam inerentemente perigosas, os cibercriminosos estão tentando encontrar formas eficientes de usar modelos de linguagem, alimentando assim uma tendência de redução da barreira de entrada no crime cibernético e, em alguns casos, aumentando potencialmente o número de ataques cibernéticos”, ressalta Kulishenko.

No entanto, acrescenta a analista, é improvável que a Inteligência Artificial Generativa e os chatbots revolucionem o cenário dos ataques, pelo menos em 2024, mas que é crucial para estar à frente dos adversários em termos de segurança cibernética corporativa.

- Quer ganhar mais com Ethereum? Abra sua conta no Mercado Bitcoin, a corretora mais segura do Brasil, e comece a fazer staking agora mesmo