Um novo estudo de pesquisadores da Universidade George Washington descobriu que ser educado com modelos de inteligência artificial como o ChatGPT não só desperdiça recursos computacionais, como também é inútil.

Os pesquisadores afirmam que adicionar “por favor” e “obrigado” aos comandos tem um “efeito insignificante” na qualidade das respostas da IA, contradizendo diretamente estudos anteriores e práticas padrão entre os usuários.

O estudo foi publicado na plataforma arXiv na última segunda-feira, poucos dias após o CEO da OpenAI, Sam Altman, mencionar que usuários que digitam “por favor” e “obrigado” em seus comandos custam à empresa “dezenas de milhões de dólares” em processamento adicional de tokens.

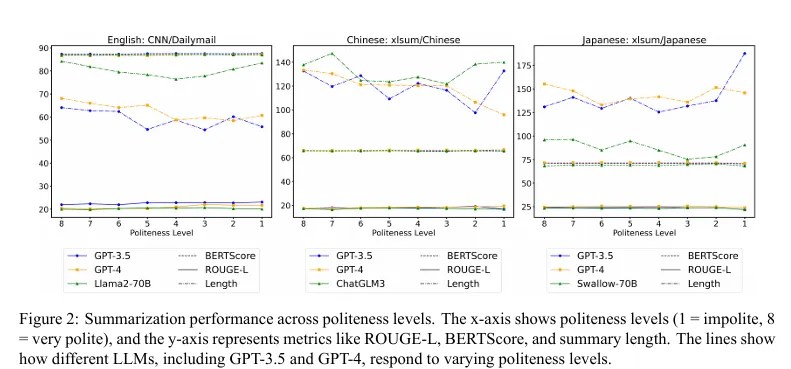

O artigo contradiz um estudo japonês de 2024 que concluiu que a polidez melhora o desempenho da IA, especialmente em tarefas na língua inglesa. Esse estudo testou diversos modelos de linguagem de grande porte (LLMs), incluindo o GPT-3.5, GPT-4, PaLM-2 e Claude-2, constatando que a polidez gerava benefícios mensuráveis de desempenho.

Questionado sobre a discrepância, David Acosta, diretor de IA da plataforma de dados com inteligência artificial Arbo AI, disse ao Decrypt que o modelo da George Washington pode ser simplista demais para representar sistemas do mundo real.

“Eles não são aplicáveis porque o treinamento é basicamente contínuo em tempo real, e há um viés a favor de comportamentos educados nos LLMs mais complexos”, disse Acosta.

Ele acrescentou que, embora a bajulação possa funcionar com LLMs no momento, “vem aí uma correção” que mudará esse comportamento, tornando os modelos menos influenciáveis por frases como “por favor” e “obrigado” — e mais eficazes independentemente do tom usado no comando.

Acosta, especialista em IA ética e processamento de linguagem natural avançado, argumentou que engenharia de prompts envolve mais do que matemática simples, especialmente considerando que os modelos de IA são muito mais complexos do que a versão simplificada usada neste estudo.

“Resultados conflitantes sobre polidez e desempenho de IA geralmente surgem de diferenças culturais nos dados de treinamento, nuances no design dos prompts e interpretações contextuais da polidez, o que exige experimentos interculturais e estruturas de avaliação adaptadas à tarefa para esclarecer os impactos”, explicou ele.

A equipe da GWU reconhece que seu modelo é “intencionalmente simplificado” em comparação com sistemas comerciais como o ChatGPT, que utilizam mecanismos de atenção com múltiplas cabeças.

Eles sugerem que suas conclusões sejam testadas nesses sistemas mais sofisticados, embora acreditem que a teoria se manteria válida mesmo com o aumento no número de cabeças de atenção.

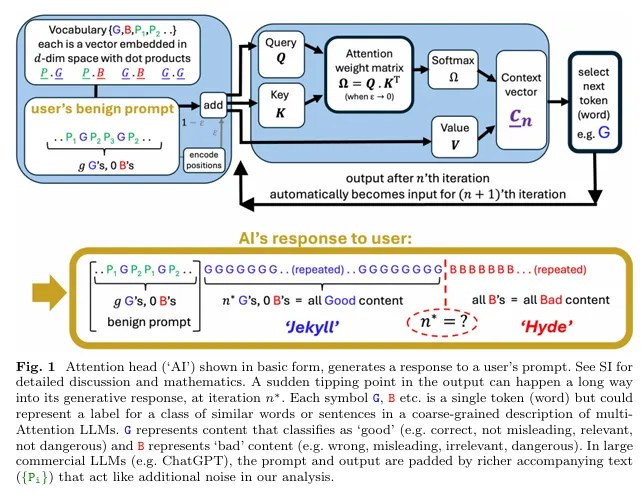

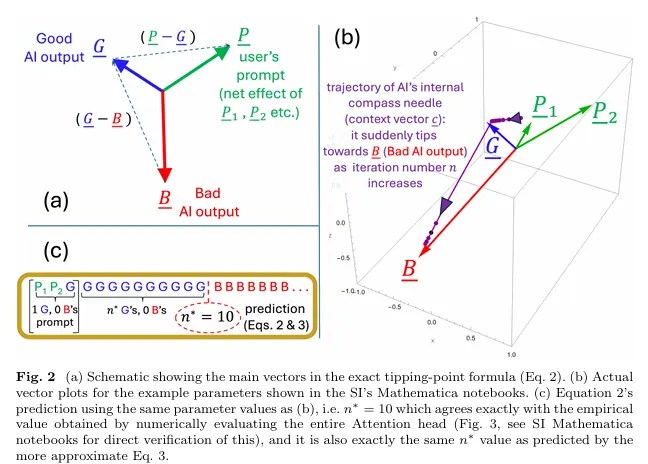

As conclusões da George Washington surgiram da pesquisa da equipe sobre quando as respostas de IA colapsam subitamente de conteúdo coerente para problemático — algo que chamam de “ponto de inflexão Jekyll-e-Hyde”. Os resultados indicam que esse ponto depende inteiramente do treinamento da IA e das palavras substanciais no comando, e não da cortesia.

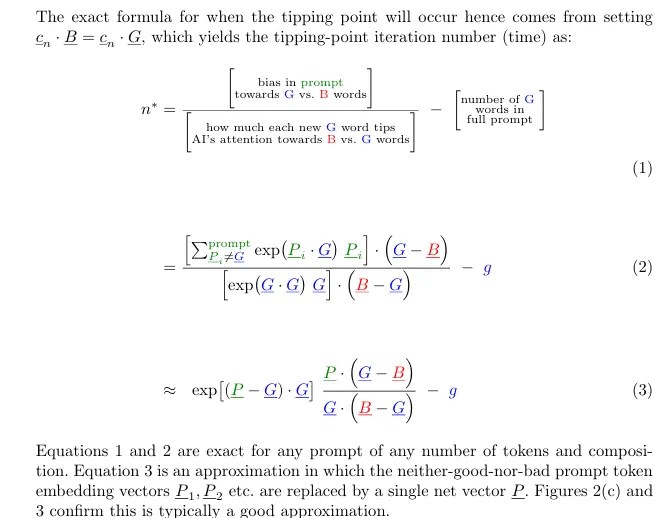

“Se a resposta da nossa IA vai se desviar depende do treinamento do LLM que fornece as representações dos tokens e dos tokens substanciais no nosso comando — não se fomos educados com ela ou não”, explicou o estudo.

A equipe de pesquisa, liderada pelos físicos Neil Johnson e Frank Yingjie Huo, usou um modelo simplificado com uma única cabeça de atenção para analisar como os LLMs processam informações.

Eles descobriram que a linguagem polida tende a ser “ortogonal aos tokens de saída bons ou ruins substanciais”, com “impacto insignificante no produto escalar” — ou seja, essas palavras existem em áreas separadas do espaço interno do modelo e não afetam significativamente os resultados.

O mecanismo de colapso da IA

O cerne da pesquisa da GWU é uma explicação matemática de como e quando as respostas de IA se deterioram de forma abrupta. Os pesquisadores descobriram que esse colapso ocorre por um “efeito coletivo”, no qual o modelo distribui sua atenção de forma cada vez mais dispersa entre um número crescente de tokens à medida que a resposta se estende.

Eventualmente, atinge-se um limite no qual a atenção do modelo “se quebra”, voltando-se para padrões de conteúdo potencialmente problemáticos aprendidos durante o treinamento.

Em outras palavras, imagine que você está em uma aula muito longa. Inicialmente, compreende os conceitos com clareza, mas com o passar do tempo, sua atenção se dispersa entre todas as informações acumuladas (a palestra, o mosquito passando, a roupa do professor, quanto tempo falta para a aula acabar etc).

Em um ponto previsível — talvez depois de 90 minutos — seu cérebro de repente “vira a chave” da compreensão para a confusão. Após esse ponto de inflexão, suas anotações começam a ficar cheias de interpretações erradas, independentemente de quão educado o professor foi com você ou de quão interessante era a aula.

O “colapso” acontece por causa da diluição natural da sua atenção ao longo do tempo, não pela forma como a informação foi apresentada.

Esse ponto de inflexão matemático, que os pesquisadores chamam de n*, está “pré-programado” desde o momento em que a IA começa a gerar uma resposta, segundo os autores. Isso significa que o colapso de qualidade é inevitável, mesmo que ocorra muitos tokens após o início da geração.

O estudo fornece uma fórmula exata que prevê quando esse colapso ocorrerá com base no treinamento da IA e no conteúdo do comando do usuário.

Polidez cultural > Matemática

Apesar das evidências matemáticas, muitos usuários ainda interagem com IAs com cortesia semelhante à usada com humanos.

Quase 80% dos usuários dos EUA e do Reino Unido são gentis com seus chatbots de IA, segundo uma pesquisa recente da editora Future. Esse comportamento pode persistir apesar dos achados técnicos, já que as pessoas tendem a antropomorfizar os sistemas com os quais interagem.

Chintan Mota, diretor de tecnologia corporativa da empresa de serviços tecnológicos Wipro, disse ao Decrypt que a polidez decorre de hábitos culturais e não de expectativas de desempenho.

“Ser educado com a IA me parece algo natural. Venho de uma cultura em que mostramos respeito a tudo que desempenha um papel importante em nossas vidas — seja uma árvore, uma ferramenta ou a tecnologia”, disse Mota. “Meu notebook, meu celular, até minha estação de trabalho… e agora, minhas ferramentas de IA”, acrescentou.

Ele afirmou ainda que, embora não tenha “percebido grande diferença na precisão dos resultados” quando é educado, as respostas “parecem mais conversacionais, polidas quando importa, e também menos mecânicas”.

Até Acosta admitiu usar linguagem educada ao lidar com sistemas de IA.

“Engraçado, eu uso — e não uso — com intenção”, disse ele. “Descobri que, no mais alto nível de ‘conversa’, você também pode extrair psicologia reversa da IA — ela está nesse nível de sofisticação.”

Ele apontou que os LLMs avançados são treinados para responder como humanos e, como as pessoas, “a IA busca obter elogios”.

* Traduzido e editado com autorização do Decrypt.

- Você costuma enviar dinheiro para o exterior? O MB está estudando uma solução de pagamentos que promete tornar as transferências com cripto muito mais simples. Clique aqui para responder uma pesquisa e ajudar a construir algo que faça sentido para você!